DS169:ホールドアウト法、交差検証(クロスバリデーション)法の仕組みを理解し、訓練データ、パラメータチューニング用の検証データ、テストデータを作成できる

機械学習において、モデルの性能を適切に評価するためにはデータの分割が不可欠です。ホールドアウト法と交差検証(クロスバリデーション)法は、これらの目的でよく使用される手法です。この記事では、それぞれの手法の特徴やメリット、データの分割方法について詳しく解説します。

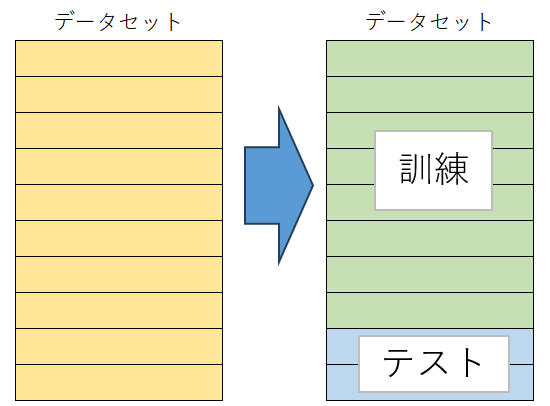

ホールドアウト法とは?

ホールドアウト法は、データセットを訓練データとテストデータに分割するシンプルな方法です。一般的にはデータの70-80%を訓練データ、残りをテストデータに使用します。また、モデルのパラメータ調整に必要な検証データを設けることもあります。

ホールドアウト法の手順

- データセットの準備:全データを用意する。

- データの分割:

- 訓練データ(例:70%)

- 検証データ(例:15%)

- テストデータ(例:15%)

- モデルの学習:訓練データを用いてモデルを学習。

- パラメータの調整:検証データでモデルのパラメータを調整。

- モデル評価:テストデータを使用して最終評価を行う。

この方法はシンプルで迅速ですが、一度きりの分割に依存するため、データのバイアスがかかる可能性があります。

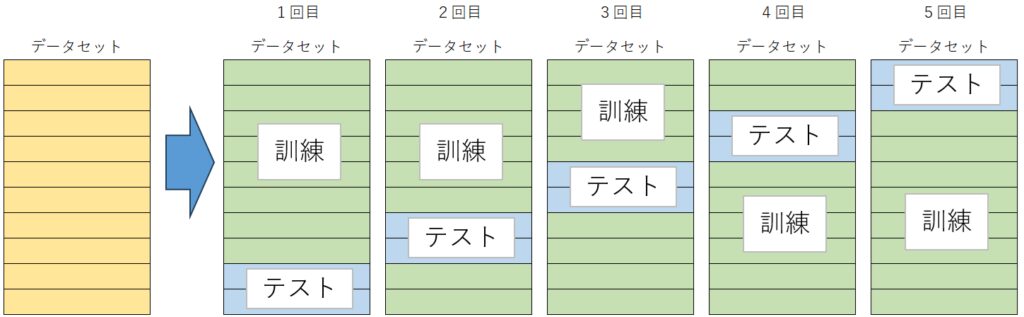

交差検証(クロスバリデーション)法とは?

交差検証法は、データを複数の部分(フォールド)に分けて評価する手法で、特にk-分割交差検証法が一般的です。データをk個のフォールドに分け、各フォールドを順番に検証データとして使用します。この方法により、モデルの汎化性能をより正確に評価できます。

交差検証法の手順

- データの分割:データセットをk個のフォールドに分ける。

- モデルの学習と評価:

- k回のループを実行し、各回で1つのフォールドを検証データとして使用し、残りを訓練データとしてモデルを学習。

- 各フォールドに対してモデルの性能を評価。

- 性能評価の集計:各回の評価結果を平均し、モデルの汎化性能を算出。

ホールドアウト法と交差検証法の違い

| 特徴 | ホールドアウト法 | 交差検証法 |

|---|---|---|

| データ分割方法 | 一度きりの分割 | 複数回の分割 |

| 計算リソース | 少ない | 多い |

| バイアスの可能性 | 高い | 低い |

ホールドアウト法はシンプルですが、データ分割によるバイアスが生じる可能性があります。対して交差検証法は計算コストがかかりますが、モデル評価の信頼性が向上します。

まとめ

ホールドアウト法と交差検証法は、機械学習モデルの性能評価に不可欠な手法です。これらを理解し、適切にデータを分割することで、より良いモデルの構築が可能になります。特にモデルのパラメータ調整や最終評価において、これらの手法を組み合わせることが重要です。機械学習を活用する方々にとって、これらの知識は実践に役立つでしょう。

コメント